Audio2Face тепер доступне за відкритою ліцензією MIT. Цей інструмент на базі генеративного ШІ призначений для анімації облич ігрових персонажів та синхронізації рухів губ зі звуковим потоком розповідає 24 Канал з посиланням на NVIDIA.

Дивіться також Nvidia оновила драйвер: гравці отримають кращу графіку в Indiana Jones та Wuthering Waves

Як Audio2Face змінює анімацію в іграх?

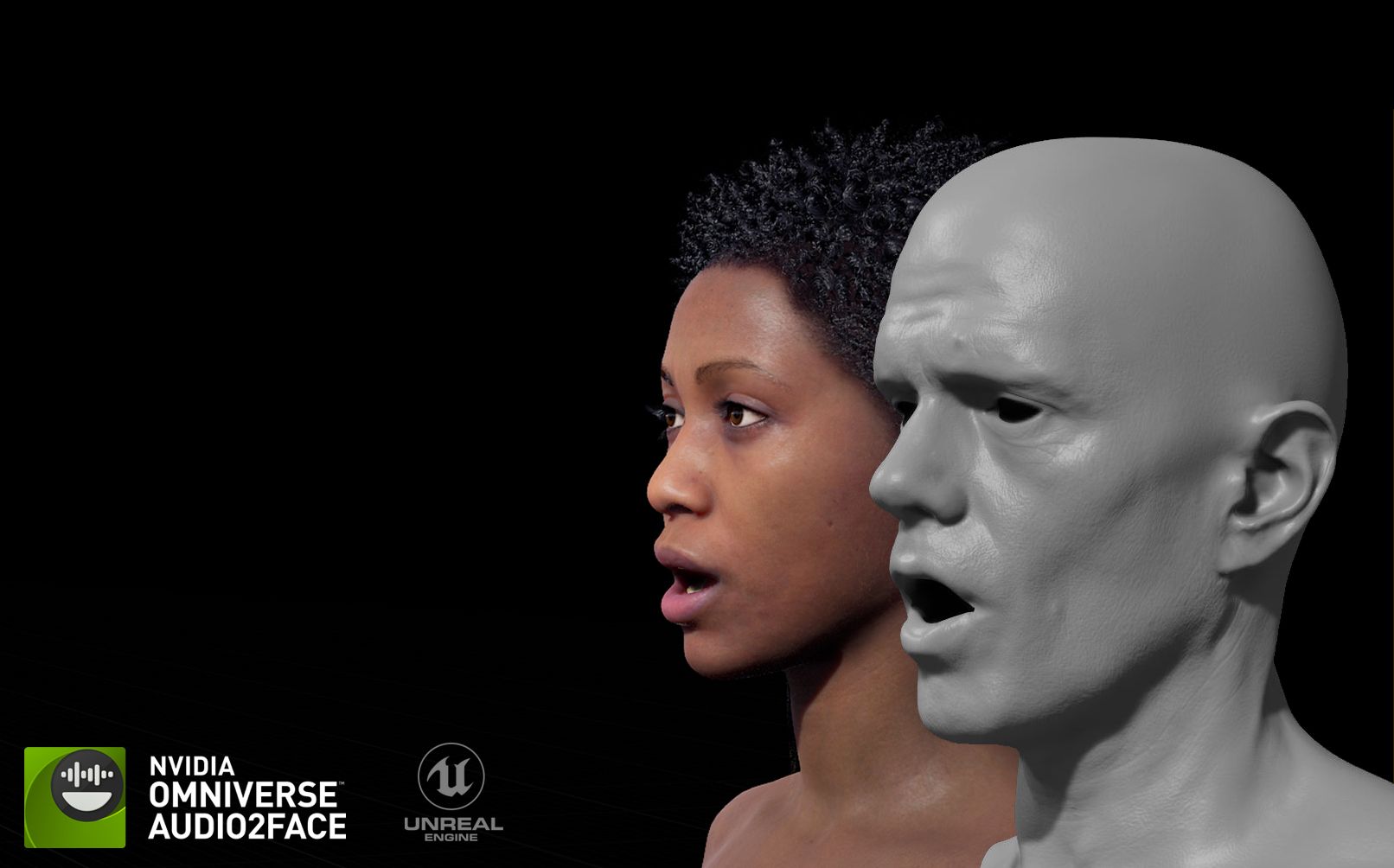

Технологія аналізує звук мови, враховуючи фонеми, інтонацію та емоційний тон, і на основі цього генерує потоки даних. Потім ці дані застосовуються до тривимірних моделей, роблячи їхню поведінку більш виразною та реалістичною.

Інструмент інтегрується у популярні рушії, такі як Unreal Engine 5 та Autodesk Maya, у форматі плагінів. Nvidia також підготувала SDK, фреймворк для навчання та приклади наборів даних. Це дозволяє розробникам самостійно доопрацьовувати наявні моделі або адаптувати їх для власних проєктів.

Для синхронізації губ використовуються регресійні та дифузійні моделі ШІ, а для розпізнавання емоційного стану персонажа за голосом – нейромережа Audio2Emotion.

Як виглядає Audio2Face – дивіться відео:

Хтось вже застосовує цю технологію?

Технологія Audio2Face вже активно застосовується у виробництві ігор, розповідає videocardz. Студія The Farm 51 використала її для створення Chernobylite 2: Exclusion Zone, щоб прискорити процес анімації та зробити артикуляцію персонажів природнішою. З інструментом також працюють Codemasters, GSC Game World, NetEase, Perfect World та інші.

Система дозволяє відмовитись від традиційних методів захоплення руху, що високо цінують студії, які прагнуть прискорити розробку.

Audio2Face є частиною набору інструментів для розробників RTX Kit, а його випуск у відкритий доступ дає змогу адаптувати технологію до ширшого спектра застосувань.