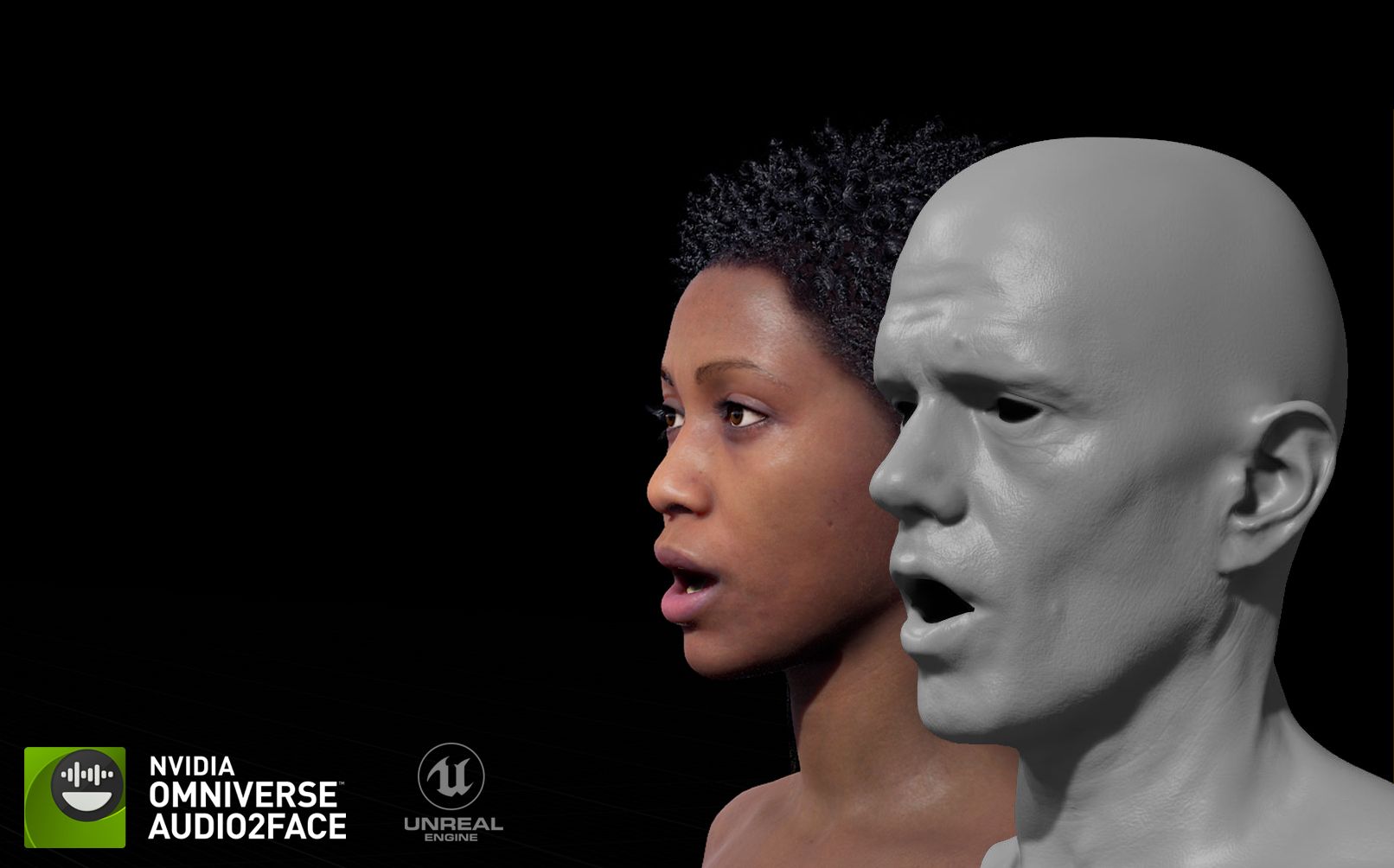

Audio2Face теперь доступно по открытой лицензии MIT. Этот инструмент на базе генеративного ИИ предназначен для анимации лиц игровых персонажей и синхронизации движений губ со звуковым потоком рассказывает 24 Канал со ссылкой на NVIDIA.

Смотрите также Nvidia обновила драйвер: игроки получат лучшую графику в Indiana Jones и Wuthering Waves

Как Audio2Face меняет анимацию в играх?

Технология анализирует звук речи, учитывая фонемы, интонацию и эмоциональный тон, и на основе этого генерирует потоки данных. Затем эти данные применяются к трехмерным моделям, делая их поведение более выразительным и реалистичным.

Инструмент интегрируется в популярные движки, такие как Unreal Engine 5 и Autodesk Maya, в формате плагинов. Nvidia также подготовила SDK, фреймворк для обучения и примеры наборов данных. Это позволяет разработчикам самостоятельно дорабатывать имеющиеся модели или адаптировать их для собственных проектов.

Для синхронизации губ используются регрессионные и диффузионные модели ИИ, а для распознавания эмоционального состояния персонажа по голосу – нейросеть Audio2Emotion.

Как выглядит Audio2Face – смотрите видео:

Кто-то уже применяет эту технологию?

Технология Audio2Face уже активно применяется в производстве игр, рассказывает videocardz. Студия The Farm 51 использовала ее для создания Chernobylite 2: Exclusion Zone, чтобы ускорить процесс анимации и сделать артикуляцию персонажей более естественной. С инструментом также работают Codemasters, GSC Game World, NetEase, Perfect World и другие.

Система позволяет отказаться от традиционных методов захвата движения, что высоко ценят студии, которые стремятся ускорить разработку.

Audio2Face является частью набора инструментов для разработчиков RTX Kit, а его выпуск в открытый доступ позволяет адаптировать технологию к более широкому спектру приложений.